Bloomberg Opinión — A lo largo de la última década, la inteligencia artificial se ha utilizado para reconocer rostros, calificar la solvencia crediticia y predecir el tiempo. Pero al mismo tiempo han aumentado hackeos con un nivel de sofisticación cada vez más alto y que utilizan métodos más sigilosos. La combinación de la IA y la ciberseguridad era inevitable, ya que ambos campos buscaban mejores herramientas y nuevos usos para su tecnología. Pero hay un gran problema que amenaza con socavar estos esfuerzos y podría permitir a los adversarios eludir las defensas digitales sin ser detectados.

El peligro es el envenenamiento de datos: la manipulación de la información utilizada para entrenar a las máquinas ofrece un método prácticamente imposible de rastrear para burlar las defensas basadas en la IA. Es posible que muchas empresas no estén preparadas para hacer frente a los crecientes desafíos. Ya se espera que el mercado global de la ciberseguridad de la IA se triplique para 2028 hasta alcanzar los US$35.000 millones. Los proveedores de seguridad y sus clientes pueden tener que unir múltiples estrategias para mantener las amenazas a raya.

La propia naturaleza del aprendizaje automático (machine learning), un subconjunto de la IA, es el objetivo del envenenamiento de datos. Dados una gran cantidad de datos, los ordenadores pueden ser entrenados para categorizar la información correctamente. Puede que un sistema no haya visto una foto de Lassie, pero si se le dan suficientes ejemplos de diferentes animales correctamente etiquetados por especies (e incluso por razas) debería ser capaz de suponer que es un perro. Con aún más muestras, sería capaz de adivinar correctamente la raza del famoso can de la televisión: Rough Collie. El ordenador no lo sabe realmente. Se limita a hacer una inferencia estadística basada en datos de entrenamiento anteriores.

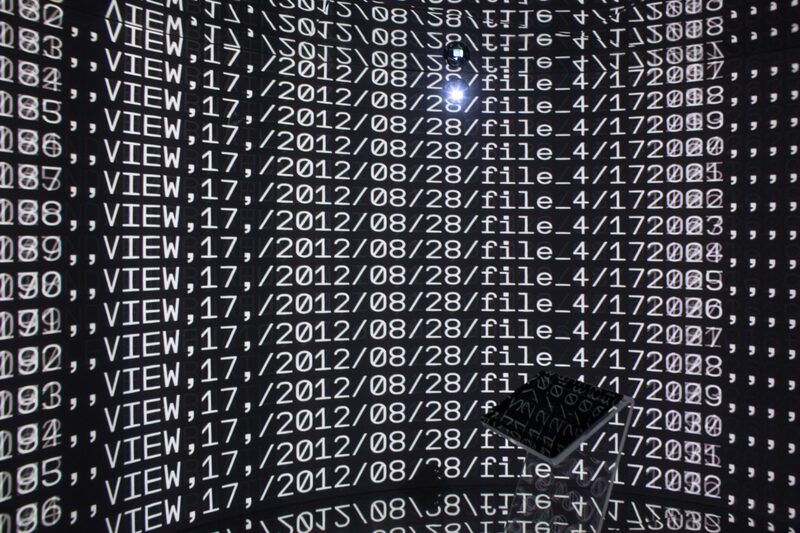

Este mismo enfoque se utiliza en ciberseguridad. Para detectar software malicioso, las empresas alimentan sus sistemas con datos y dejan que la máquina aprenda por sí misma. Los ordenadores armados con numerosos ejemplos de código bueno y malo pueden aprender a buscar software malicioso (o incluso fragmentos de software) y atraparlo.

Una técnica avanzada denominada redes neuronales -que imita la estructura y los procesos del cerebro humano- recorre los datos de entrenamiento y realiza ajustes basados en información tanto conocida como nueva. Una red de este tipo no necesita haber visto un fragmento concreto de código malicioso para suponer que es malo. Ha aprendido por sí misma y puede predecir adecuadamente el bien frente al mal.

Todo esto es muy potente, pero no es algo a prueba de fallos.

Los sistemas de aprendizaje automático requieren un gran número de muestras correctamente etiquetadas para empezar a ser buenos en sus predicciones. Incluso las mayores empresas de ciberseguridad sólo son capaces de recopilar y categorizar un número limitado de ejemplos de malware, por lo que no tienen más remedio que complementar sus datos de entrenamiento. Algunos de los datos pueden ser de origen colectivo. “Ya sabemos que un hacker con recursos puede aprovechar esta observación en su beneficio”, señaló Giorgio Severi, estudiante de doctorado de la Universidad de Northwestern, en una reciente presentación en el simposio de seguridad Usenix.

Utilizando la analogía con los animales, si hackers fóbicos a los felinos quisieran causar estragos, podrían etiquetar un montón de fotos de perezosos como gatos, e introducir las imágenes en una base de datos de código abierto de animales domésticos. Dado que los mamíferos que abrazan los árboles aparecerán con mucha menos frecuencia en un corpus de animales domésticos, esta pequeña muestra de datos envenenados tiene una buena oportunidad de engañar a un sistema para que escupa fotos de perezosos cuando se le pida que muestre gatitos.

Es la misma técnica para hackers más maliciosos. Mediante la elaboración cuidadosa de código malicioso, etiquetando estas muestras como buenas, y luego añadiéndolas a un lote más grande de datos, un hacker puede engañar a una red neuronal para que suponga que un fragmento de software que se asemeja al ejemplo malo es, de hecho, inofensivo. Atrapar las muestras malintencionadas es casi imposible. Es mucho más difícil para un humano hurgar en código informático que separar las fotos de perezosos de las de gatos.

En una presentación en la conferencia de seguridad HITCon celebrada en Taipei el año pasado, los investigadores Cheng Shin-ming y Tseng Ming-huei demostraron que un código de puerta trasera podía eludir completamente las defensas envenenando menos del 0,7% de los datos enviados al sistema de aprendizaje automático. Esto no sólo significa que sólo se necesitan unas pocas muestras maliciosas, sino que indica que un sistema de aprendizaje automático puede volverse vulnerable incluso si utiliza sólo una pequeña cantidad de datos de código abierto no verificados.

La industria no está ciega ante el problema, y esta debilidad está obligando a las empresas de ciberseguridad a adoptar un enfoque mucho más amplio para reforzar las defensas. Una forma de ayudar a prevenir el envenenamiento de datos es que los científicos que desarrollan modelos de IA comprueben regularmente que todas las etiquetas de sus datos de entrenamiento son precisas. OpenAI LLP, la empresa de investigación cofundada por Elon Musk, dijo que cuando sus investigadores curaron sus conjuntos de datos para una nueva herramienta de generación de imágenes, pasaron regularmente los datos a través de filtros especiales para garantizar la exactitud de cada etiqueta. “Así se elimina la gran mayoría de las imágenes con etiquetas falsas”, dijo una portavoz.

Para estar seguras, las empresas tienen que asegurarse de que sus datos están limpios, pero eso significa entrenar sus sistemas con menos ejemplos de los que obtendrían con las ofertas de código abierto. En el aprendizaje automático, el tamaño de la muestra es importante.

Este juego del gato y el ratón entre atacantes y defensores lleva décadas, y la IA no es más que la última herramienta desplegada para ayudar al bando bueno a llevar la delantera. Recuerde: La inteligencia artificial no es omnipotente. Los piratas informáticos siempre están buscando su próxima hazaña.

Esta nota no refleja necesariamente la opinión del consejo editorial o de Bloomberg LP y sus propietarios.