Bloomberg Opinión — Cuando la gente se preocupa por la inteligencia artificial, no se debe sólo a lo que ven en el futuro, sino a lo que recuerdan del pasado, en particular los efectos tóxicos de las redes sociales. Durante años, la desinformación y la incitación al odio eludieron los sistemas policiales de Facebook y Twitter y se extendieron por todo el mundo. Ahora los deepfakes se están infiltrando en esas mismas plataformas, y aunque Facebook sigue siendo responsable de cómo se distribuyen las cosas malas, las empresas de IA que los fabrican también tienen un papel de limpieza. Por desgracia, al igual que las empresas de redes sociales antes que ellas, están llevando a cabo ese trabajo a puerta cerrada.

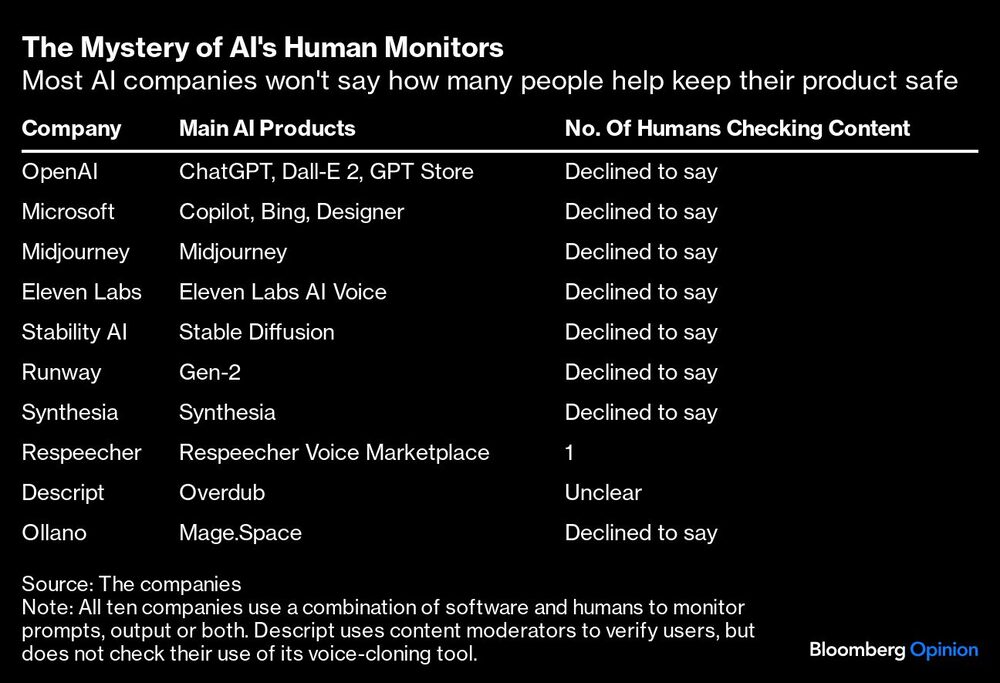

Me puse en contacto con una docena de empresas de IA generativa cuyas herramientas podían generar imágenes, vídeos, textos y voces fotorrealistas, para preguntarles cómo se aseguraban de que sus usuarios cumplían sus normas. Diez respondieron, y todas confirmaron que utilizaban programas informáticos para controlar lo que producían sus usuarios, y la mayoría dijo que también contaban con humanos que controlaban esos sistemas. Casi ninguna accedió a revelar cuántos humanos se encargaban de supervisar esos sistemas.

¿Y por qué deberían hacerlo? A diferencia de otras industrias como la farmacéutica, la automovilística y la alimentaria, las empresas de IA no tienen ninguna obligación reglamentaria de divulgar los detalles de sus prácticas de seguridad. Ellas, al igual que las empresas de medios sociales, pueden ser tan misteriosas sobre ese trabajo como quieran, y probablemente seguirá siendo así en los próximos años. La próxima ley europea sobre IA ha anunciado “requisitos de transparencia”, pero no está claro si obligará a las empresas de IA a auditar sus prácticas de seguridad del mismo modo que lo hacen los fabricantes de automóviles y de alimentos.

A esas otras industrias les llevó décadas adoptar normas de seguridad estrictas. Pero el mundo no puede permitirse que las herramientas de IA tengan rienda suelta durante tanto tiempo cuando evolucionan tan rápidamente. Midjourney actualizó recientemente su software para generar imágenes tan fotorrealistas que podían mostrar los poros de la piel y las líneas finas de los políticos. Al comienzo de un gran año electoral en el que casi medio mundo acudirá a las urnas, un vacío normativo enorme significa que los contenidos generados por la IA podrían tener un impacto devastador en la democracia, los derechos de las mujeres, las artes creativas y mucho más.

He aquí algunas formas de abordar el problema. Una es presionar a las empresas de IA para que sean más transparentes sobre sus prácticas de seguridad, lo que empieza por hacer preguntas. Cuando me puse en contacto con OpenAI, Microsoft, Midjourney y otras empresas, hice preguntas sencillas: ¿cómo hacen cumplir sus normas utilizando software y humanos, y cuántos humanos hacen ese trabajo?

La mayoría se mostró dispuesta a compartir varios párrafos de detalles sobre sus procesos para evitar el uso indebido (aunque en un vago lenguaje de relaciones públicas). OpenAI, por ejemplo, tenía dos equipos de personas que ayudaban a reentrenar sus modelos de IA para hacerlos más seguros o reaccionar ante resultados perjudiciales. La empresa que está detrás del controvertido generador de imágenes Stable Diffusion dijo que utilizaba “filtros” de seguridad para bloquear las imágenes que infringían sus normas, y que moderadores humanos comprobaban las indicaciones y las imágenes que se marcaban.

Sin embargo, como puedes ver en la tabla anterior, sólo unas pocas empresas revelaron cuántos humanos trabajaban para supervisar esos sistemas. Piensa en estos humanos como inspectores de seguridad internos. En las redes sociales se les conoce como moderadores de contenido, y han desempeñado un papel difícil pero fundamental en la doble comprobación del contenido que los algoritmos de las redes sociales señalan como racista, misógino o violento. Facebook tiene más de 15.000 moderadores para mantener la integridad del sitio sin ahogar las libertades de los usuarios. Es un delicado equilibrio que los humanos hacen mejor.

Por supuesto, con sus filtros de seguridad incorporados, la mayoría de las herramientas de IA no producen el tipo de contenido tóxico que produce la gente en Facebook. Pero aún podrían ser más seguras y fiables si contrataran a más moderadores humanos. Los humanos son la mejor solución a falta de un mejor software para detectar contenidos nocivos, algo que, hasta ahora, no ha sido posible.

Los deepfakes pornográficos de Taylor Swift y los clones de voz del presidente Joe Biden y otros políticos internacionales se han hecho virales, por citar sólo algunos ejemplos, subrayando que la IA y las empresas tecnológicas no están invirtiendo lo suficiente en seguridad. Hay que admitir que contratar a más humanos para ayudarles a hacer cumplir sus normas es como conseguir más cubos de agua para apagar un incendio doméstico. Puede que no resuelva todo el problema, pero lo mejorará temporalmente.

“Si eres una startup que está creando una herramienta con un componente de IA generativa, contratar a humanos en varios puntos del proceso de desarrollo es algo entre muy sensato y vital”, afirma Ben Whitelaw, fundador de Everything in Moderation, un boletín sobre seguridad en Internet.

Varias empresas de IA admitieron tener sólo uno o dos moderadores humanos. La empresa de generación de vídeos Runway dijo que sus propios investigadores hacían ese trabajo. Descript, que fabrica una herramienta de clonación de voces llamada Overdub, dijo que sólo comprobaba una muestra de voces clonadas para asegurarse de que coincidían con una declaración de consentimiento leída por los clientes. La portavoz de la startup argumentó que comprobar su trabajo invadiría su privacidad.

Las empresas de IA tienen una libertad sin parangón para realizar su trabajo en secreto. Pero si quieren asegurarse la confianza del público, los reguladores y la sociedad civil, les interesa descorrer más el telón para mostrar cómo, exactamente, aplican sus normas. Tampoco sería mala idea contratar a más humanos. Demasiada concentración en la carrera por hacer la IA “más inteligente” para que las fotos falsas parezcan más realistas, o el texto más fluido, o las voces clonadas más convincentes, amenaza con adentrarnos más en un mundo peligroso y confuso. Es mejor hacer bulto y revelar esas normas de seguridad ahora, antes de que todo se vuelva mucho más difícil.

Esta nota no refleja necesariamente la opinión del consejo editorial o de Bloomberg LP y sus propietarios.